메타를 떠난 얀 르쿤 '세 번째 혁명은 현실을 이해하는 AI'

이번 주 전 세계 테크 생태계는 인도 뉴델리에 주목하고 있습니다.바로 “인도 AI 정상 회의 2026” 때문인데요. 여러 세션이 열렸지만, 본지는 프랑스의 컴퓨터 과학자 얀 르쿤의 세션에 주목했습니다. 얀 르쿤은 현재 뉴욕 대학교 쿠란트 수학 연구소의 교수이며, 지난해 11월 메타의 AI 수석 과학자직을 그만둔

이번 주 전 세계 테크 생태계는 인도 뉴델리에 주목하고 있습니다.

바로 “인도 AI 정상 회의 2026” 때문인데요.

여러 세션이 열렸지만, 본지는 프랑스의 컴퓨터 과학자 얀 르쿤의 세션에 주목했습니다.

얀 르쿤은 현재 뉴욕 대학교 쿠란트 수학 연구소의 교수이며,

지난해 11월 메타의 AI 수석 과학자직을 그만둔 후

어드밴스드 머신 인텔리전스 랩스(AMI 랩스)를 설립, 이사회 의장직을 맡고 있습니다.

이날 얀 르쿤 교수는 현재 AI 업계를 신날 하게 비판했는데요.

특히 대규모 언어 모델(LLM)의 한계를 정면으로 비판했습니다.

그리고 그 대안으로 ‘세계 모델(World Model)’이라는 새로운 패러다임을 제시했는데요.

약 30분간 진행된 그의 발표와 대담 세션을 아래와 같이 정리했습니다.

AI의 역설 — “텍스트 데이터는 이미 한계에 다다랐다”

LLM이 다음 단어를 예측한다면, 세계 모델은 무엇을 예측하는가

인간의 진짜 강점은 ‘아는 것’이 아니라 ‘빨리 배우는 것’이다

이 내용을 중심으로 오늘 글을 시작하겠습니다.

1. AI의 역설 — “텍스트 데이터는 이미 한계에 다다랐다”

얀 르쿤 교수는 무대에 서자마자 AI가 현재 처한 “역설적인 상황”을 날카롭게 꼬집었습니다.

그는 현재 AI가

어려운 변호사 시험에 합격하고 수학 올림피아드 문제를 척척 풀어내지만

정작 고양이 수준의 판단력을 가지고

실제 물리 세계에서 움직이는 로봇은 아직 나오지 못하고 있다는 점을 짚었습니다.

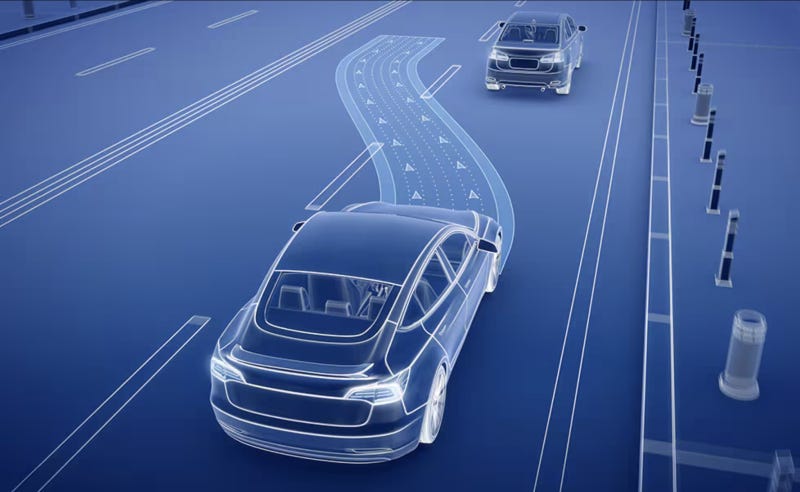

물론 완전 자율주행차도 마찬가지입니다. 수백만 시간의 주행 데이터를 학습시켜도 인간의 운전 실력을 따라잡기 벅차다는 것이 그의 분석이었습니다.

반면, 17살 청소년은 단 20시간 정도만 연습하면 운전을 배울 수 있습니다.

그렇다면 이런 격차는 왜 생길까요?

얀 르쿤 교수는 그 원인으로 “텍스트 데이터”가 가진 물리적 한계를 꼽았습니다.

현재 모든 텍스트의 데이터량은 10의 14제곱 바이트 정도인데요.

이 수치는 사람이 태어나서 4년 동안 눈으로 받아들이는 시각 정보의 양과 비슷한 수준이었습니다.

동시에 유튜브 영상으로 치면 고작 3분 분량에 불과했습니다.

즉, 영상 데이터의 관점에서 보면 텍스트 데이터는 아주 적은 양인 셈입니다. 실제로 메타가 훈련해 온 시각 인식 시스템들은 이미 이보다 수십 배나 많은 데이터를 학습 중이었습니다.

여기에 더해 얀 르쿤 교수는 현재 대규모 언어 모델(LLM)의 구조적인 결함도 지적했습니다.

현재 LLM을 구성하는 요소, 즉 트랜스포머 블록 수는 정해져 있는데요. 다시 말해 어떤 질문이 들어오든 단어 하나(토큰)를 만드는 데 사용하는 계산량이 똑같다는 뜻이기도 합니다.

“2 더하기 2는?” 같은 쉬운 질문이나, 수학의 난제인 “P-NP 문제”를 풀 때나 시스템은 정확히 같은 양의 계산을 수행하고 있었습니다. 이 문제를 해결하기 위해 업계에서는 ‘사고 연쇄(Chain-of-Thought)’라는 기법이 쓰이기도 합니다.

인위적으로 답변 과정을 길게 늘려 계산량을 확보하는 방식입니다.

하지만 이 과정에서 전달되는 정보는 고작 3바이트짜리 토큰 하나뿐이라는 한계가 있었습니다.

이 지점에서 얀 르쿤 교수는 AI가 인간의 사고방식과는 근본적으로 다르다고 강조했습니다.

사람은 결국 언어라는 자체 도구보다는 ‘정신 모델(Mental Model)’로 생각하기 때문입니다.

머릿속으로 공중에 떠 있는 정육면체를 상상하고,

이를 90도 돌렸을 때의 모양을 떠올리는 직관적인 추론은 언어와 상관없이 이루어지는데요.

코드를 짜거나 수학 문제를 풀 때처럼

기호를 사용하는 사고는 인간 지능의 아주 특수하고 작은 부분일 뿐이라는 것.

그것이 얀 르쿤 교수의 설명이었습니다.

“ 텍스트 데이터는 정보가 충분히 중복되어 있지도 않고,

한 번에 전달되는 정보량(대역폭)도 크지 않다.AI가 스스로 학습하는 ‘자기 지도학습’은 데이터 속에 반복되는 구조가 있어야 제대로 작동한다.

완전히 무작위인 데이터로는 아무것도 배울 수 없기 때문이다.AI 시스템은 데이터의 중복성을 바탕으로

세상이 어떻게 돌아가는지 그 구조를 발견해 내고 있다.”

이런 상황에서 얀 르쿤 교수는 텍스트 데이터는 이미 다 써 버렸다고 보고 있었습니다.

여기에 더해 그 안에 담긴 정보의 밀도도 한계에 다다랐다고 진단했습니다.

그렇다면 얀 르쿤 교수는 어떤 대안을 제시했을까요?

2. LLM이 다음 단어를 예측한다면, 세계 모델은 무엇을 예측하는가

얀 르쿤 교수가 이날 인도에서 제시한 10년 넘게 연구한 AI에 대한 해법은 바로 ‘세계 모델(World Model)’이었습니다.

세계 모델은 본질적으로 다음에 일어날 일을 맞히는 ‘예측기’라고 할 수 있는데요.